软件环境hadoop下载教程的搭建也很重要,包括Hadoop及相关组件的安装配置,以及集群管理工具的选择等因此,建议参考官方文档和相关教程,以确保集群的稳定运行总之,构建Hadoop集群需要综合考虑硬件配置和软件环境,以满足特定的数据处理需求在实际操作中,可以根据具体需求和预算进行调整,以达到最佳的性能和成本平衡;以下是关于05 Spark安装Standalone模式和YARN模式集群的详细步骤11 环境与版本准备从Linux浏览器下载spark330安装包,下载地址,将其移动至opt目录并解压22 配置Spark环境变量 进入配置文件,添加新的Spark路径至环境变量,确保其在Hadoop路径前,以便正确启动Spark 启用配置文件。

hadoop下载教程你看的教程是旧的,新版的hadoop启动脚本放在sbin下startallsh已经逐渐被废弃,采用新的启动脚本sbinhadoopdaemonsh script hdfs start datanodesbinhadoopdaemonsh script hdfs start namenodesbinyarndaemonsh start resourcemanagersbinyarndaemonsh start proxyserversbin;首先,通过SSH登录到你的虚拟机环境,确认环境配置无误对于首次登录,可能会出现安全提示,选择“是”继续,然后按照提示配置无密码登录,确保安全连接安装Java环境,选择最新版本,确保系统能够正常运行Hadoop在配置文件中添加Java路径和版本信息,检查是否已正确设置接下来,下载Hadoop最新版本的安装包。

Docker最核心的特性之一,就是能够将任何应用包括Hadoop打包到Docker镜像中这篇教程介绍了利用Docker在单机上快速搭建多节点 Hadoop集群的详细步骤作者在发现目前的Hadoop on Docker项目所存在的问题之后,开发了接近最小化的Hadoop镜像,并且支持快速搭建任意节点数的Hadoop集群一 项目简介 GitHub kiwan;Hadoop中有很多方法可以加入多个数据集MapReduce提供了Map端和Reduce端的数据连接这些连接是非平凡的连接,并且可能会是非常昂贵的操作Pig和Hive也具有同等的能力来申请连接到多个数据集Pig提供了复制连接,合并连接和倾斜连接skewed join,并且Hive提供了map端的连接和完整外部连接来分析数据一。

搭建 Windows IDEA 与虚拟机 Hadoop 集群连接流程概述1 前置准备确保在虚拟机上已成功部署 Hadoop 全分布式集群,并下载所需工具IDEA破解版 IDEA 导入教程winutilsexe 和 hadoopdll2 创建 Maven 项目在 IDEA 中创建新项目,并确保已配置 JDK 环境打开 pomxml 文件,配置引入;hadoophdfs610129jar hadoopmapreduceclientcore610129jar hadoopyarnapi610129jar 其实就是hadoop相关的,然后就可以了以上四步中,官方文档有第二步,第三步,第一步在网上其他教程中也能够解决但是,第四部,官方文档中没。

下载Hive 400的稳定版本,解压并配置环境变量配置Hivesitexml,包括元数据存储选择和驱动文件放置初始化Hive元数据并管理Hive服务使用Hive创建数据库表,以及支持Iceberg的分区表参考资源详尽教程hive400 + hadoop334 集群安装Tez 安装和部署说明Hive 官方文档Hadoop 335 集群。

hadoopcommon下载

jdk6u27linuxi586由于hadoop对版本的要求较高,大家还是不要轻易更换版本,这里列出来的各种软件都是稳定发布版,网上很容易可以download到的整个教程分为这样5个部分来说1在Windows下安装虚拟机Vmware,并新建一个虚拟机装好centos系统2centos下设置ssh服务无密码登录3centos下安装。

#160#16032位04ubuntu1604desktopi386iso #160#16064位04ubuntu1604desktopamd64iso 解决方案直接删除namenode的配置文件目录,在重新format 1 cd hadoophadoop121bin 2 stop。

首先,安装Docker Desktop,确保在Windows系统中已删除WSL中的Docker并按照参考文档操作接着,利用Docker Compose工具定义多容器应用Docker Compose允许通过YAML文件配置服务,使用一个命令启动所有服务详细使用方法和命令可见菜鸟教程了解如何进入和退出Docker容器,以及如何在容器中运行PySpark客户端此外。

hadoop官网下载教程

1hadoop安装包下载2登录启动成功后访问IP,登录默认用户名和密码 UsernameadminPassword 3集群指定主机安装过程中请不要刷新页面4集群安装DKM各组件安装这里有3种安装方式 “基本安装”,“完整安装”,“自定义安装”5开始安装组件我以“基本安装”方式来进行示。

实际上,安装Hadoop并不仅仅依赖于Cygwin的usrbin目录,更重要的是确保Hadoop的安装路径和环境变量配置正确安装Hadoop时,建议选择一个合适的安装目录,比如D盘,并在环境变量中正确配置Hadoop的路径具体操作步骤可以参考网络上的教程,有许多详细的指导可以帮助用户顺利完成Hadoop的安装和配置总之,虽然。

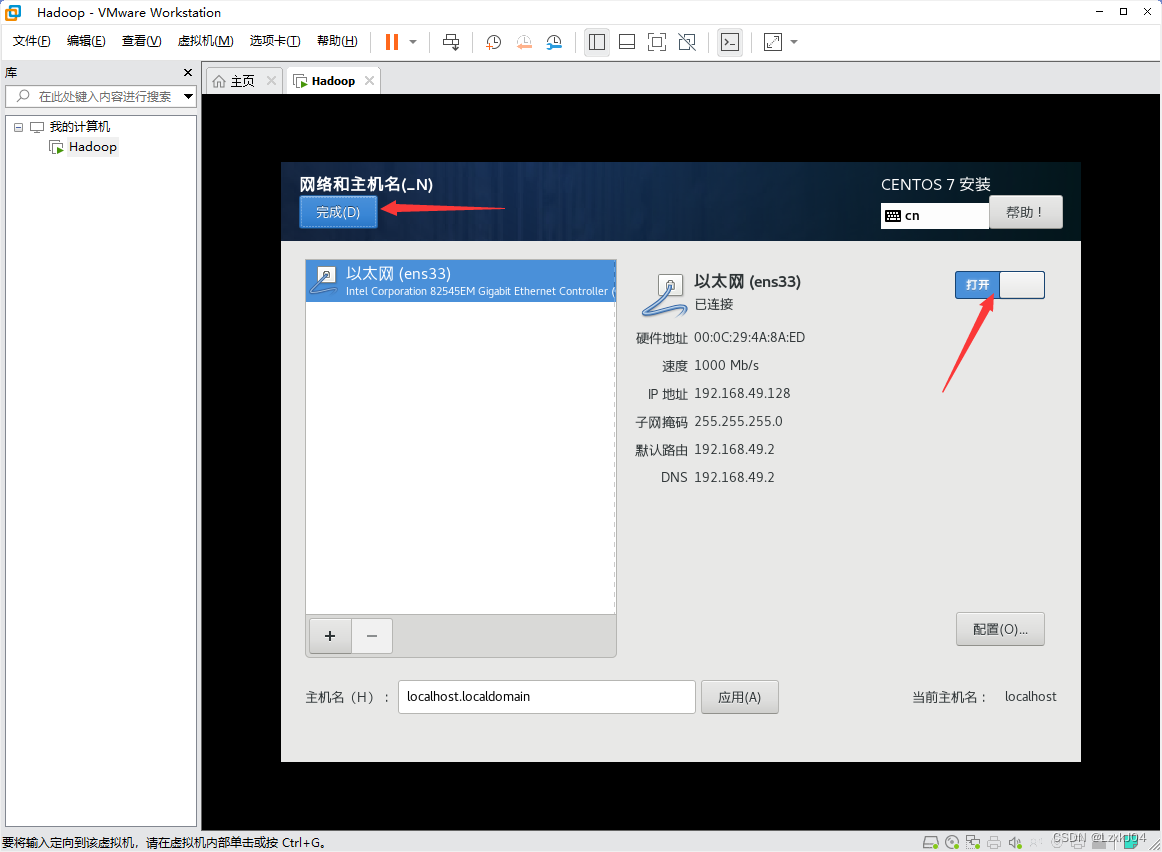

安装jdk查看Linux是否安装java jdk,卸载原有包后下载并安装jdk8,配置环境变量,使配置文件生效并验证Hadoop单机模式搭建从官网下载hadoop336targz,解压安装包并配置环境变量,格式化HDFS,验证安装完成伪分布模式搭建配置免密登录,修改hdfs配置文件并格式化HDFS,配置YARN,启动Hadoop集群。

为了安装Zookeeper,首先需要确保JDK环境,以JDK18为例,通过yum管理器安装然后下载Zookeeper382安装包,将其重命名并放置在指定目录下创建数据和日志目录,并复制配置文件,修改相关配置项以满足需求启动脚本用于运行Zookeeper,可以通过bin目录下的启动文件实现此外,需要注意防火墙端口的配置。

经过研究后知道,首先Cygwin下不能使用windows的路径直接访问,需要是Linux风格的目录,如果是访问C盘下安装的JDK的话,不能使用“CProgram FilesJavajdk160_22”,而需要使用这样“cygdrivecProgram FilesJavajdk160_22”其次是hadoop好像不能识别带空格的目录路径,那怎么办呢,想。